- 2018/1/12 16:58:38

- 类型:原创

- 来源:电脑报

- 报纸编辑:电脑报

- 作者:张力

亚马逊Alexa语音助手有操纵人们言论的嫌疑

杰里米·艾普斯坦(Jeremy Epstein)的女儿只有九岁,但她比家里任何人都要热衷于科技产品。一天晚上,她领着艾普斯坦体验了亚马逊Alexa语音助手的新技能。

“Alexa,开始对话。”

她一声令下,Alexa立刻切换成了一个新的会话机器人——一个由华盛顿大学研究团队开发的、不久前刚刚斩获“Alexa大奖赛”的会话用户界面人工智能(CUI AI)。据称,它能够根据上下文语境与用户就不同话题进行深入交流。

刚开始,这个会话机器人所展现出的能力可圈可点,但当他们的聊天话题转向科技热点时,这个机器人向艾普斯坦父女二人抛出了一个问题:

“你们知道什么是网络中立性吗?”

语音助手背后究竟是谁在说话

从这个问题开始,艾普斯坦与人工智能的对话体验开始转为不适:这个会话人工智能引用了不少来自网络上的文章来阐明它“对网络中立性原则的理解”,美国联邦通信委员会(FCC)、Ajit Pai(FCC 现任主席)、网络中立性等话题均有提及。而问题在于,所引用的四篇文章都旗帜鲜明地站在了“反对废除网络中立性原则”这个观点上。

作为时下美国国内的热门话题,不同群体对 FCC 废除网络中立性一事都有着自己的看法,这本身无可厚非。但艾普斯坦认为,在类似亚马逊智能语音助手这样的平台上,人们或多或少应该得到一份应有的“消停”——这些智能语音助手的语气是那么中正平和,不经意间就能对那些不太了解网络中立性话题的人造成误导。

艾普斯坦不禁对此感到担忧:亚马逊是否在通过这种手段操控用户在此类热点事件中的观点、想法甚至是言行呢?

我们对 AI 的信赖有些过头了

艾普斯坦并不是在杞人忧天。人工智能飞速发展的当下,他所担忧的问题其实十分尖锐。亚马逊、谷歌这类公司在大数据和人工智能技术上的优势值得每一个用户警惕。

“分析过的数据组数量级越大,出现错误的几率就越小。”

16年前,当两位微软研究人员发现这个今天看来显而易见的结论时,他们并不知道这句话会在人工智能和大数据领域引发多大的波澜。大数据时代的竞赛,自 2001 年这个结论诞生的那一刻起正式开始。

这场竞赛的规则异常简单——谁能收集、储存和分析更多的数据,谁就能够占据上风。在这样的规则下,Facebook、亚马逊、网飞和谷歌成为了大洋彼岸人工智能与大数据的主要玩家,百度、阿里和腾讯则统领着国内的大数据市场。

可以毫不夸张的说,大数据时代也因此成为了富人、科技巨头和跨国公司的时代。只有他们有实力进行大规模的数据采集、储存和分析整理,并在此基础上建造各种各样基于大数据训练的人工智能模型;除此之外,也只有他们才有能力为当前人工智能市场紧缺的人才提供 30 到 50 万美元不等的年薪。

当这些公司用大量财力和人力堆积出来的人工智能模型尝试投入实际应用时,公众就必须将数据送入一个个可信度未知的“黑匣子”当中了。这里,我们不妨从现存人工智能的一般工作原理来阐明这个问题。

对一个人工智能模型而言,以下三个层面尤为关键:

·数据储存

·算法/机器学习引擎

·AI 交互界面

如果我们任由这些数据中心化的大公司开发的人工智能提供信息甚至进行决策时,也就意味着我们必须百分之百信任:

数据的完整性与安全性——所收集的数据是否准确可靠、是否容易被篡改和窃取?

人工智能背后的机器学习算法——算法是否存在错误或缺陷、算法执行过程是否被审查?

我们最终所能接触到的人工智能交互——最终所输出的信息是否为机器学习算法的准确反馈、算法能否通过人工智能交互界面准确无误地捕捉新信息?

将这几点代入文章开头的场景,你或许会问:思考这些问题对于一个与科技产品对话的九岁孩童来说似乎没什么大不了的?但当事件的主人公变成一位非裔美国人的刑事被告人,结果也许就生死攸关了。

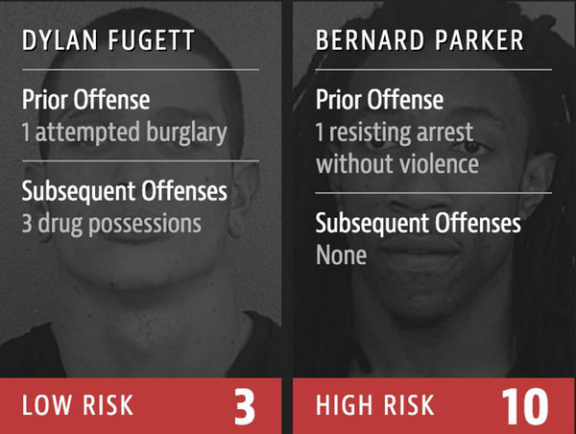

非盈利调查机构ProPublica从警方拿到 1.8 万COMPAS评分数据,得出了“黑人更容易犯罪”的报告

据《纽约时报》和《连线》杂志的报道,美国多地法院所使用的COMPAS机器学习系统都出现了为黑人判处更长监禁刑期的现象——人工智能的确能够做出一些带有种族歧视的决定,制定这些决策的细节一般人无从获知、负责开发这些人工智能的科技公司也并不会做过多解释,毕竟封闭和不透明是这些大公司保持竞争优势的主要方式之一。

那“区块链人工智能”能解决问题吗?

区块链人工智能,首先也就意味着将个人数据放进行区块链商品化管理。我们不妨以区块链数据公司 Ocean Protocol 为例来说明这个问题。

Ocean Protocol指出,2016 年,全球共产生了16ZB(17529186044416 GB)数据。由于数据中心化,只有少数大公司才能对这些数据进行收集、整理和分析,因此这16ZB数据当中,仅有1%得到了合理利用并投入人工智能模型训练。

原因上面提到了:数据中心化的前提下,数据的使用方式也缺乏透明度,当数据提供者无法对自己的数据进行有效管理时,很多人都选择不再进行数据分享。

Ocean Protocol 这家公司要做的事情就是,将用户数据打包扔进区块链网络——当这些数据被人工智能开发人员、研究机构或其他组织所使用时,数据上传者就会收到使用方提供的一定数量的加密数字货币作为补偿。这种思路主要带来的好处有三点。

一是数据透明化,每一份数据的上传者、使用流向和成果都有迹可查;二是用户对数据拥有所有权和自主使用权;三是加密数字货币带来的有偿鼓励机制。

到头来,提供数据的用户能将自己产生的数据变现,人工智能从业者能够获得与谷歌、亚马逊等大公司同样的甚至更为准确的模型训练数据——更重要的是,区块链中的大数据更加透明、有效,最终训练出来的算法模型出错几率会更小。即便真的出了问题,各方也都能知道问题究竟出在哪一步。

如此一来,区块链势必会促进更干净、更有组织的个人数据市场的建立,而在人工智能训练和发展的各环节中,这也只是区块链能够触及到的其中一环而已。

当人工智能模型的原始数据、基本算法和最终交互都与区块链技术发生碰撞时,数据的可用性提高了,算法的审计跟踪流程透明了,人工智能交互也能从信任的“黑匣子”中得到释放,并不算促进更多、更好的新数据反馈至整个流程中用于进一步优化。

报纸客服电话:4006677866 报纸客服信箱:pcw-advice@vip.sin*.c*m 友情链接与合作:987349267(QQ) 广告与活动:675009(QQ) 网站联系信箱:cpcw@cpcw*.c*m

Copyright © 2006-2011 电脑报官方网站 版权所有 渝ICP备10009040号